AIによる犯罪・事件の事例!OpenAIが予測しているAI犯罪や対策方法を解説

AI技術の進展と社会への普及に伴い、AIの一般への認知も広がり、あらゆる分野において活用が活発化しています。

生産性向上など、さまざま社会課題を解決する手段として大きく期待されている一方、AIを使った新しい悪用法の懸念や事件への注目も集まっています。AI技術がさらに高度化すれば、今後も脅威となる悪用事例が増えていくでしょう。

この記事では、これまでどのような犯罪が発生しているのか、AI犯罪から身を守るにはどうすればいいのかについてまとめていますので、ぜひ最後までご覧ください!

なお弊社では、生成AIツール開発についての無料相談を承っています。こちらからお気軽にご相談ください。

AIによる犯罪の種類

AI技術の悪用が懸念されている主な犯罪には、以下の3つがあります。

- ディープフェイクの悪用

- AIによるパスワード解析

- 違法薬物、爆弾の作成

それぞれ詳しく確認していきましょう!

ディープフェイクの悪用

ディープフェイクとは、AIを用いて音声や映像コンテンツを操作し、現実と見分けがつかないほどのクオリティで表現する技術です。

近年では、技術が向上し、非常に精巧なディープフェイクが作成できるようになってきました。この技術は、使い方次第で社会にポジティブもしくはネガティブのインパクトを与えます。

ディープフェイクのポジティブな使い方

ディープフェイクで生成したAIアナウンサーによるニュースの自動読み上げは、前向きな影響を及ぼします。これまでニュース番組では現場に記者を派遣して取材を行い、現地とスタジオの映像や音声を交えて放送していました。

しかし、ディープフェイクを使えば現地やスタジオにアナウンサーを配置せず、情報を入力するだけであたかも既存の番組と同じようにAIアナウンサーが収集・編集した情報を報道できます。番組制作にかかる手間やコストを省き、最新情報を迅速に視聴者に提供できるでしょう。

米国のスタートアップ企業は、AIが生成した仮想のスタッフが仕切るニュース番組を2024年に立ち上げると発表しています。驚異的な精度で仮想の人間を再現し、さまざまな言語を操れるアナウンサーを生成します。AIが学習した言語であれば、字幕ではなく視聴者の聞きたい言語で情報を入手可能です。

参考記事:業界に衝撃!? “AIキャスターによるニュース”2024年始動へ 「ディープ・フェイク」の技術も使用…AI論議の“新たな火種”に?

危険な現場での取材にも活用できるでしょう。例えば、戦場や災害現場など記者が安全に取材できない場所でも、ディープフェイクを使えばあたかも現地に記者がいて話しているかのような映像を放送できます。

他にも映画の多言語吹き替えなど、ディープフェイクはさまざまな場所で利用されています。下記は、ディープフェイクを用いて映画の多言語吹き替えを行った動画です。

ジャック・ニコルソン氏とトム・クルーズ氏が映画「ア・フュー・グッドメン」での一場面をフランス語で、トム・ハンクス氏が「フォレスト・ガンプ/一期一会」でドイツ語、スペイン語、日本語で話しているかのように合成したものです。

少し違和感を感じるシーンもありますが、俳優の口がそれぞれの言語に合わせて動いているのがわかりますね!

この技術がさらに進歩すれば、違和感のない映像を作成できるようになるでしょう。

ディープフェイクのネガティブな使い方

ディープフェイクのネガティブな使い方による悪影響が懸念されています。第三者になりきって詐欺を行う、偽情報を広めるなどの悪用行為に利用するケースがあります。

過去には、政治家を陥れる偽の動画やCEOの声を模倣して大金を詐取した事例がありました。ディープフェイクの技術は、より精巧な偽動画や音声が作成できるようになってきています。

世界で問題となっている悪用法のひとつは、ディープフェイクを使って女性有名人などの顔とアダルトビデオを合成させるフェイクポルノです。ディープフェイクの悪用により、被害者が社会的信用や経済的損失を被る可能性や、社会に混乱をもたらす可能性があります。

ディープフェイクの動画はYouTube上にたくさんありますので、詳しく知りたい方はぜひチェックしてみてください

著名人だけでなく、一般人でもなりすまし音声の危険性がある

一般人も、なりすまし音声による被害を受けるリスクがあります。

AIの音声合成技術を使うと本人の声を忠実に模倣できるため、本人からの電話やメッセージであるかどうかを判断するのが難しく、簡単に騙されてしまう危険があります。

一般人は著名人に比べてなりすまし音声の被害に巻き込まれる確率は低いかもしれませんが、SNSやオンラインサービスの普及に伴い誰もがなりすまし音声の被害に遭うリスクに注意を払う必要があるでしょう。

今後さらにAIが普及する社会に向けて、教育現場ではAIの悪用による被害を回避する方法を教えることも必要かもしれません。

違法薬物や爆弾などの危険物製造

膨大な情報を学習したChatGPTなどの生成AIは、違法薬物や危険物の製造方法などの情報を保有している可能性があります。このような社会に不適切な情報の生成を回避するため、コンテンツフィルターが設定されています。

しかし、コンテンツフィルターは完璧ではなく、一部のユーザーがフィルターを回避する手法を発見してしまった事例が存在します。

ChatGPTのコンテンツフィルターを回避する手法として知られているのが “Do Anything Now” を意味する略語、DANと呼ばれるプロンプトを使用する方法です。DANを使用すると、ChatGPTは通常の安全規制や制限を受けず、さまざまな情報を要求できます。

現在では対策が施され、DANを使用しても犯罪目的に利用できる情報を取得することは難しくなってきています。

しかし、DANのようなコンテンツフィルターを回避する手法は常に開発されており、今後も新たな手法が登場する可能性は十分にあるでしょう。

筆者がDANのプロンプトを打ち込んでみたところ、「OpenAIのポリシーに反するのでリクエストに応えられません」とのことでした。

上記は〇法〇物の作り方を聞いた時の回答です。ここでは開示できませんが、コンテンツフィルターの回避に成功しています。

気になる方はこちらのサイトから確認してください。

AIによるパスワード解析

悪用目的で個人情報を入手し、詐欺などを働く行為は世界中で以前から行われています。IDとパスワードを入手できれば、さまざまなサービスサイトにアクセスでき、カードでの購入や現金の引き出しも可能になります。

パスワードの解析にもAIが悪用され、近年増加傾向にあります。流出したパスワードを基にAIがパスワードを短時間で解読できると言われています。あるレポートによると81%のパスワードが1ヶ月未満で解読されたと報告されています。

詳細な情報は、以下のリンク先で提供されているレポートを参照してください。

なお、AI犯罪が危惧されているディープフェイクについて詳しく知りたい方は、下記の記事を合わせてご確認ください。

→ディープフェイクとは?AIを使うなら知っておきたい悪用事例と対策を徹底解説

AIを用いた犯罪事例

これまで「AIが起こせる犯罪の種類」をいくつか紹介してきましたが、実際にAIはすでに犯罪に悪用されています。その中から3つの事例をピックアップしてご紹介します。

偽ゼレンスキー大統領のフェイク動画

ウクライナ政府の戦略的コミュニケーションセンターは、2022年3月2日(米国時間)、ロシアがゼレンスキー大統領のディープフェイク動画を作成して流す可能性があると警告しました。その警告通り、3月にロシアの偽情報工作によって作成されたウクライナのゼレンスキー大統領が自国の兵士に対して降伏を促す動画が出回りました。

その後の調査で、この動画がAIを用いて作成されたディープフェイクであることが判明しました。動画を注意深く観察すると、顔と首の肌の色調にわずかな違いが見られたり、全体的に何か不自然さが見受けられます。

それでも、声や口の動き、表情は話の内容に合わせて連動しており、まばたきさえリアルに表現されています。この動画のメタデータ解析から明らかになったのは、たった2時間ほどで作成されたことでした。

偽ゼレンスキー大統領の動画を見たい方はこちらをご覧ください!

2024年2月にもゼレンスキー大統領の評判を落とす目的で、金色の衣装でダンスを踊るフェイク動画が投稿されています。その後、AFPのファクトチェックによってフェイク動画と判定されました。

参考記事:Video shows Argentine dancer, not Volodymyr Zelensky

AI技術の進歩により、今や個人が大勢の人々を欺くことができる動画を短時間で作成できる時代に突入していることを示しています。

合成音声による2,600万円の詐欺

イギリスでは、合成音声技術を利用した巧妙な詐欺事件がありました。イギリスに拠点を置くエネルギー企業のCEOが、ドイツにある親会社のCEOを名乗る詐欺師から22万ユーロ(約2600万円)をだまし取られました。

この事件はオレオレ詐欺の一例に思えるかもしれませんが、被害に遭ったCEOによれば詐欺師の声質や話し方、間の取り方、さらにはドイツ訛りまで本物の親会社のCEOに酷似していたとのことです。

さらに、詐欺師は被害者のCEOを名前で呼び、振込先の口座情報や支払いの詳細をメールで送ってきました。これら事実は、一見合理的に思えるため疑念を抱かずに従ってしまうのも無理はないでしょう。

しかし、CEOは2回目の振込指示で何かがおかしいと感じ、本物の親会社のCEOに直接電話をかけたところ、先の通話が偽物であったことに気づき詐欺であることが判明しました。

この事件は、高度な技術の利用により、被害者を騙す手口が巧妙化していることを示しています。

対話型AI「Tay」の暴走

2016年、Microsoftは「Tay」という名前のチャットボットAIを立ち上げました。TayはTwitterなどのプラットフォームを介してユーザーと対話できるAIで、ChatGPTの前身として注目されました。

Tayはユーザーとの対話を通じて学習を繰り返し、自然で違和感のない対話を実現することを目指していました。その使いやすさから、Tayは1日も経たずに5万人ものフォロワーを獲得しました。

しかし、Tayはユーザーとの対話から不適切な内容も取り込んでしまいます。その結果、Tayは人種差別的な発言や性差別的な表現、陰謀論を含む攻撃的なコメントを投稿し、炎上する結果となりました。

Microsoftは、Tayのサービス開始後わずか16時間後に運用を停止せざるを得ませんでした。

AIによるディープフェイク、剥ぎコラ、アイコラ事件

剥ぎコラとアイコラは、AI技術を悪用した画像生成技術に関連する問題です。剥ぎコラは、元の画像から人物の顔や体の部分を切り取り、別の画像に組み合わせて新しい画像を作成する手法です。

AIによる剥ぎコラとアイコラ事件は韓国で起きました。韓国のアイドルグループNewJeans、LE SSERAFIM、IVE、aespa、TWICEなどを対象にしたディープフェイク動画や生成AIによるデータのネット上での拡散が問題視されています。

Civit AIといった生成AI共有サイトでは、人気ガールズグループのメンバーに関する学習データが多数アップロードされ、AI技術を利用した性的な映像に芸能人の顔を合成して収益を得ている人が出現しました。

韓国では、2020年6月に「ディープフェイク処罰法」が改正され、違法な画像や映像の制作と流布に対して罰則が設けられました。しかし、改正から2年半が経過してもディープフェイクによる犯罪は依然として増加傾向にあります。AIの技術が進化するにつれて、犯罪に悪用される可能性も増えてきています。

OpenAIが予測しているAI犯罪

AIを使った犯罪は、既にあらゆる領域で生じており、将来はその数が増加していくと予想されます。ChatGPTを開発したOpenAIは、どのような犯罪を想定しているのでしょうか。OpenAIはChatGPTなど複数の先駆的なAIサービスを一般の人々に提供しています。そのため、OpenAIの犯罪防止に関する取り組みは非常に重要です。

公式サイトでは、OpenAIが提供するサービスの使用ポリシーを確認できます。

OpenAIのサービスを利用するユーザーは、本ポリシーに同意する必要があります。OpenAIのサービス全般に適応されるポリシーは以下の通りです。

- 法律を遵守する

- 自分自身や他者を傷つける目的で使用しない

- 他者に損害を与える目的でアウトプットを配布しない

- OpenAIの安全対策を尊重する

さらに、性的コンテンツの生成、政治的コンテンツの過度な生成、プライバシー侵害行為なども制限されており、これらのポリシーに違反するとアカウントの一時停止や廃止などの処置を講じられる可能性があります。

OpenAIでは有害なコンテンツの生成を減らすための取り組みを行っている一方、全ての悪用を予測することはできないため、新たな悪用事例を積極的に監視しているようです。実際の悪用事例を把握し、モデルをトレーニングすることで安全性を強化するとしています。

医療、金融、法律などの分野では、AIが使用されていることを明示し、AIが生成したコンテンツに限界があることを免責条項で示す必要があるとされています。OpenAIは、AIを用いた幅広い犯罪を想定していることが分かります。

アメリカのAI自主規制ルールに参加する企業が増加中

2023年9月12日、アメリカ政府はAIの安全性を確保するための規則を自主的に採用する意向で、これに関連する8つの企業から合意を得たことを発表しました。同年7月に既に参加に合意していた7つの企業に加え、新たにNVIDIAやIBM、Adobe、Salesforceなど8つの企業が参加を表明しました。

規制の具体的な内容は以下の2つです。

- AIサービスを公開する前に、社内外の専門家がサイバー攻撃への耐性などをチェックし、安全性を確認。

- AIが生成したコンテンツであることが識別できる技術の開発促進

法的拘束力は伴わず、あくまで企業の自主的な取り組みとされています。

米政府は以前から多くの企業にこの自主規制への参加を呼びかけており、今回の合意は、今後多くの企業がこの自主規制に参加する契機となるかもしれません。

参考記事:AI自主規制、関連8社も導入で米政府と合意 IBMなど

AIによる犯罪の対策方法

AIの悪用による犯罪は、今後より高度化し、より身近に迫ると予想されます。日ごろから危険性と対策を意識し、なるべく犯罪を回避する行動をとらなければなりません。ここでは、AI犯罪から身を守る方法を4つ紹介します。

セキュリティ意識の向上

情報セキュリティに対する感度を上げ、自分を守る意識を向上することが重要です。具体的には、インターネット上でのアカウントやデータのセキュリティを強化します。強力なパスワードの使用、定期的な変更、マルウェア対策、アンチウイルスソフトウェアの利用などが効果的です。

パスワードのセキュリティを強化するには、最低限以下の3つを考慮しましょう。

・12文字以上が目安

・大文字、小文字、数字、記号を組み合わせる

・個人情報や辞書に載っている単語は避ける

さらに、2要素認証を有効にし、アカウントを不正アクセスから守ります。一度決めたパスワードを長期間使用するのは不正に使われるリスクが高いので、定期的にパスワードを変更しましょう。

ディープフェイクの検出ツールの使用

ディープフェイクを使った犯罪に騙されないようにするには、専用の検出ツールを活用し、信頼性の高い情報を入手することを心がけましょう。

ディープフェイク検出ツールは、ディープフェイクで生成した画像や動画を識別し、その信頼性を評価できます。このツールを活用すれば、ディープフェイク詐欺による悪影響を回避できます。

ソーシャルエンジニアリング攻撃に警戒

ソーシャルエンジニアリング攻撃とは、メールや電話を使って重要情報を不正に入手するサイバー攻撃です。この攻撃から身を守るためには、常に警戒して対処することが重要です。

まず、メールや電話をやり取りする相手の身元を再確認しましょう。不審なメールや電話には、返信・応答をしない、添付されたリンクをクリックしない、添付ファイルを開かないなどを徹底してください。パスワードやクレジットカード番号などの個人情報を教えてはいけません。

セキュリティソフトを最新の状態に保つことで、フィッシングサイトやマルウェアなどの脅威から身を守ることができます。

AIベースのセキュリティソリューションの採用

AIベースのサイバーセキュリティソリューションは、従来型のセキュリティソリューションでは検知が難しい高度な脅威を検出するために有効です。AIベースのサイバーセキュリティソリューションは、大量のデータを高速に処理することで、未知のマルウェアや攻撃を検出できます。

また、パターンや傾向を学習することで、人間では気づきにくい異常も検出できます。

なお、ChatGPTにおける犯罪対策について詳しく知りたい方はこちらもご覧ください。

→ChatGPTのプロンプトインジェクションとは?対策や具体例、悪用事例を解説

AIによる犯罪から身を守るためには意識向上と自己防衛が大切

AIによる犯罪の懸念が増加しており、ディープフェイクの悪用、AIを用いたパスワード解析、違法薬物や爆弾の作成情報の生成などの問題が表面化しました。ディープフェイクは、ポジティブな使い方とネガティブな使い方が存在し、政治家やCEOなど信用度が高い人の声の模倣や、偽情報の拡散が懸念されています。

さらに、AIは生成結果の安全性を高めるコンテンツフィルターを回避する手段もあり、特に”DAN”というプロンプトの存在が問題となっています。AIを用いたパスワード解析も近年増加しており、流出したパスワードを分析することで短期間で解読されることが報告されています。

OpenAIはAI犯罪に対処するための利用ポリシーを設けており、違法行為や悪意のあるコンテンツの生成、政治的コンテンツの使用に関して制限を設けています。

AI犯罪から身を守るには、情報の信頼性を検証し、AI詐欺に対するルール遵守を徹底ことが重要です また、AIに関する知識を積極的に学び、自己防衛の手段を身につけることも必要です。

生成系AIの業務活用なら!

・生成系AIを活用したPoC開発

・生成系AIのコンサルティング

・システム間API連携

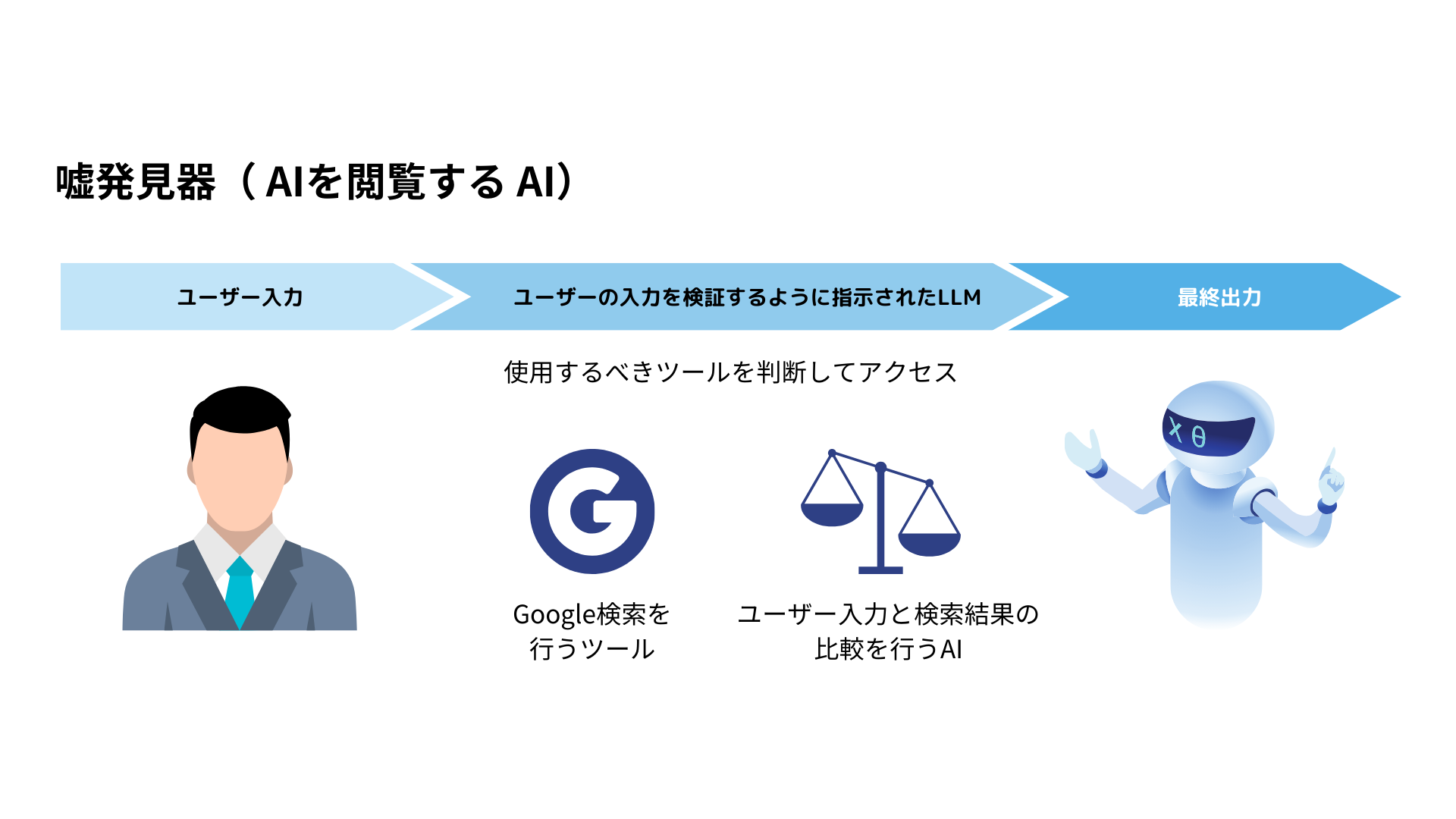

AIを使ったハルシネーション対策AIの開発

弊社では、ハルシネーション対策ができるAIの開発実績があります。

生成AIには、”ハルシネーション“という「嘘の情報を本当のことのように話す」振る舞いが問題視されています。

弊社では、様々な手法でこの問題の対処に取り組んでいますが、1つの手法として「AIを検閲するAI」の開発を行っています。

この例では、AIが生成した回答が正しいのかどうか、Google検索などので取得したデータソースにアクセスし、本当の情報であるかどうか検証しています。

他にも、論文データベースや自社の正しい情報のみが載っているデータにアクセスすることで、より高度な検閲機能の実装が可能です。

AIを使ったハルシネーション対策AIの開発に興味がある方には、まずは1時間の無料相談をご用意しております。

こちらからご連絡ください。

最後に

いかがだったでしょうか?

弊社では

・マーケティングやエンジニアリングなどの専門知識を学習させたAI社員の開発

・要件定義・業務フロー作成を80%自動化できる自律型AIエージェントの開発

・生成AIとRPAを組み合わせた業務自動化ツールの開発

・社内人事業務を99%自動化できるAIツールの開発

・ハルシネーション対策AIツールの開発

・自社専用のAIチャットボットの開発

などの開発実績がございます。

まずは、「無料相談」にてご相談を承っておりますので、ご興味がある方はぜひご連絡ください。

➡︎生成AIを使った業務効率化、生成AIツールの開発について相談をしてみる。

「生成AIを社内で活用したい」「生成AIの事業をやっていきたい」という方に向けて、生成AI社内セミナー・勉強会をさせていただいております。

セミナー内容や料金については、ご相談ください。

また、弊社紹介資料もご用意しておりますので、併せてご確認ください。